نقش داده کاوی در فرایند کشف دانش

ارنست رادفورد پدر فیزیک هسته ای و برنده جایزه نوبل فیزیک در سال 1908 بر این باور بود که ” اگر آزمایش شما به آمار نیاز دارد، شما بایستی آزمایش بهتری انجام میدادید”.

این گفته ی بسیار عمیقی است که پرداختن به آن مستلزم سرفصلی جداگانه است.

ما با الهام گیری حداقلی از این جمله چنین مینویسیم” اگر موضوعی به درستی تحلیل آماری شود، دیگر نیازی به تفسیر ندارد و نمودارها و جداول همه چیز را خواهند گفت”.

یک مشخصه بنیادین دنیای ما کمیتی بنام “داده (Data)” است که واحد اندازه گیری آن در حساب متداول بیت است. منظور از حساب متدوال به تمام محاسباتی اشاره دارد که توسط پردازنده ای مبتنی بر منطق دوجمله ای صورت میپذیرند.

هشت بیت در کنار هم یک بایت را به وجود میآورند. در علم اطلاعات یک اگزابایت داده یعنی 1018 بایت داده که تقسیم ریزتر آن بدین شرح است که هر اگزا شامل هزار پتا و هر پتا شامل هزار ترا که هر ترا شامل هزار گیگا و هر گیگا شامل هزار مگا میباشد.

در سال 2017 روزانه 2.5 اگزابایت داده در اینترنت تولید شده است.

برای نشان دادن این حجم داده خوب است به کتابخانه ی کنگره ی آمریکا فکر کنید. این کتابخانه که در شهر واشنگتن دی.سی قرار دارد دارای ظرفیت محتوایی برابر با 10 ترابایت داده مکتوب است ( در حال حاضر 30 میلیون کتاب در 470 زبان مختلف) .

حال اگر بخواهیم 2.5 اگزابایت داده تولید شده در روز ( آن هم سال 2017) را در این کنگره جاسازی کنیم باید 250000 ساختمان مشابه با آن را بسازیم تا فقط داده تولید شده در روز را در آنها قرار دهیم.

چنین روندی منجر به شکل گیری مفهومی بنام ” کلان داده (Big Data) ” گردیده، مفهومی که امروزه به وفور در جنبه های مختلفی از زندگی بشر استفاده میشود.

بهره گیری از کلان داده قطعأ مستلزم توان محاسباتی بسیاری است که تمایل به کسب چنین توانی را به خوبی میتوان در افزایش هرساله ی سرعت (نرخ زمانی) CPU مشاهده کرد به گونه ای که؛ از سال 1980 تا کنون سرعت پردازش داده تقریبأ هر سال 20% افزایش داشته است.

به عنوان نمونه، در سال 1992، متوسط سرعت پردازشگر کامپیوتر برابر با 0.05گیگاهرتز بوده این در حالی است که در سال 2005، این عدد چیزی حدود 3.6 گیگاهرتز شده است و در سال 2017 به 16 گیگاهرتز هم رسیده است.

علمای حوزه محاسبات بر این نکته اتفاق نظر دارند که کلید تبدیل کلان داده به دانش در حوزه ای بنام داده کاوی (Data Mining) نهفته است.

این حوزه از سه قسمت اساسی مهندسی داده و ذخیره سازی(Data Engineering and Storage)، تحلیل داده (Data analysis) و یادگیری ماشین (Machine learning) تشکیل شده است.

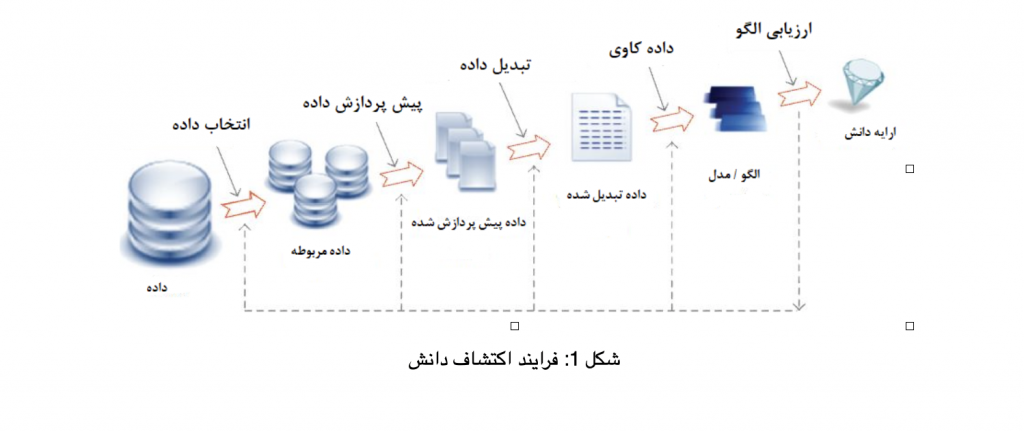

موضوع داده کاوی به قدری رواج یافته که بسیاری آن را معادل فرایند کشف دانش (Knowledge Discovery Process) در نظر میگیرند حال آنکه در واقعیت این گونه نیست و داده کاوی (DM) فقط قسمتی از فرایند کشف دانش (KDP) است. فرایند کشف دانش (KDP) شامل گامهای زیر است:

استخراج داده (Data Extraction): در این مرحله داده ها در سطحی عظیم و از منابعی متنوع استخراج می گردند.

گزینش داده(Data Selection): داده های مربوط به مسأله مورد نظر انتخاب میشوند.

پیش پردازش داده(Data Pre-processing): در این گام داده ها پیش پردازش میشوند یعنی داده های مبهم، ناقص، پرت و ناسازگار حذف میشوند.

تبدیل داده (Data Transformation): در این گام، دادهها ترکیب و به شکلی تبدیل میشوند که بتوان روی آنها تحلیل عمیق تری انجام داد.

به عنوان نمونه یک پایگاه دادهای وجود دارد که تعدادی از متغیرهای ( فیلد) و آن دارای همبستگی معنادار میباشند که میتوان این متغیرها را به یک متغیر مرکب (Composite) تبدیل کرد و داده ها را فشردهسازی (Compression) نمود.

داده کاوی (Data mining) : در این مرحله الگوریتم های داده کاوی برای استخراج الگو از دل داده ها بکار گرفته میشوند.

ارزیابی الگو (Pattern Evaluation): در این مرحله با استفاده از روشهای خاصی الگوی داده ( ساختار آماری) ان بررسی میشود.

ارایه دانش (Knowledge presentation): در این مرحله با بهرهگیری از روشهای بصریسازی (Data visualization) داده، دانش استخراج شده به متقاضییان ارایه میشود.

فرایند کشف دانش (KDP) دارای ماهیتی بازگشتی است (Recursive) ، بنابراین بعد از ارایه دانش و دریافت بازخورد امکان اصلاح یا تکرار گامهای قبلی وجود دارد ( شکل 1).

از همین نویسنده: نانوفناوری و نسل پنجم شبکههای ارتباطی

شکل 1: فرایند اکتشاف دانش

مقاله خوبی ارائه کردید متشکرم.