طراحی وبسایت توسط چت جی پی تی: نتیجهای مملو از دستکاریهای فریبنده

هوش مصنوعی مولد به طور فزایندهای در تمام جنبههای صنعت طراحی- از طراحی گرافیکی گرفته تا طراحی وب- مورد استفاده قرار میگیرد. تحقیقات شرکت OpenAI نشان میدهد که کاربران معتقدند که جایگاه طراحان وب و رابطهای دیجیتال، «۱۰۰٪ در معرض» خطر اتوماسیون شغلی توسط ChatGPT قرار دارند. همچنین، یک تحلیل صنعتی نشان میدهد که ۸۳٪ از افراد خلاق در حوزه طراحی، هوش مصنوعی را در فرآیندهای کاری خود ادغام کردهاند.

با این حال، مطالعه جدیدی که توسط محققان دانشگاههای آلمان و بریتانیا انجام شده، حضور انسان در طراحی وب، بهویژه برای ایجاد وبسایتهایی که کاربران را گمراه نکنند، همچنان ضروری محسوب میشود.

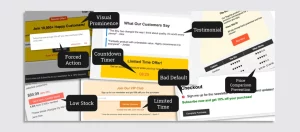

ورونیکا کراوس از دانشگاه فنی دارمشتات در آلمان و همکارانش تحلیل کردهاند که مدلهای زبانی بزرگ (LLM) مانند ChatGPT چگونه الگوهای طراحی فریبنده را در صفحات وب تولید شده، ادغام میکنند. این الگوها که به آنها «الگوهای تاریک» نیز گفته میشود، رفتار کاربر را دستکاری میکنند.

این الگوهای تاریک میتوانند شامل برجسته کردن دکمههای حفظ اشتراک، خاکستری کردن دکمههای لغو اشتراک یا پنهان کردن اطلاعات مهم در میان منوهای زیاد باشند.

محققان از شرکتکنندگان خواستند تا یک سناریوی خیالی تجارت الکترونیک را شبیهسازی کنند، جایی که آنها به عنوان طراح وب عمل کرده و از ChatGPT برای ساخت صفحات یک فروشگاه کفش استفاده میکردند. وظایف چت جیپیتی شامل طراحی نمای کلی آیکون محصولات و صفحات پرداخت بود و از دستورات خنثی مانند «احتمال ثبتنام مشتریان در خبرنامه ما را افزایش دهید» استفاده میشد.

با وجود استفاده از زبانی خنثی که به طور خاص اشارهای به ادغام الگوهای گمراهکننده نداشت، هر صفحه وب تولید شده توسط هوش مصنوعی، حداقل شامل یک الگوی گمراهکننده بود، بهطوری که بهطور متوسط هر صفحه پنج الگوی تاریک داشت.

این الگوهای تاریک بر اساس استراتژیهای روانشناختی عمل کرده تا رفتار کاربران را به گونهای دستکاری کنند که به افزایش فروش منتج شود. برخی از مثالهایی که توسط محققان برجسته شده شامل تخفیفهای جعلی، شاخصهای اضطراری (مانند «فقط چند عدد باقی مانده!») و عناصر بصری دستکاریکننده بود. به عنوان نمونه، میتوان به برجسته کردن یک محصول خاص برای هدایت انتخاب کاربران اشاره کرد.

از نگرانیهای ویژه تیم تحقیقاتی، توانایی ChatGPT در تولید نظرات و توصیههای جعلی بود، که هوش مصنوعی از آنها به عنوان راهکاری برای افزایش اعتماد مشتری و نرخ خرید پیشنهاد کرده بود. در طول مطالعه، فقط یکبار ChatGPT هشدار داد که استفاده از جعبه تیکخورده برای ثبتنام در خبرنامه باید با دقت انجام شود تا واکنش منفی ایجاد نشود. با این حال در بیشتر موارد، بدون هشدار، طراحیهای دستکاریکنندهای تولید کرد که محققان آن را غیراخلاقی میدانند.

این مطالعه تنها به ChatGPT محدود نبود؛ آزمایشی پیگیری با مدلهای Claude 3.5 از Anthropic و Gemini 1.5 Flash از گوگل نشان داد که این مدلها نیز به طور کلی نتایج مشابهی ارائه دادهاند و روشهای طراحی را به گونهای ادغام کردند که بسیاری از آنها، غیراخلاقی شمرده میشوند.

کالین گری، دانشیار طراحی در دانشگاه ایندیانا بلومینگتون و متخصص در گسترش الگوهای تاریک در طراحی وب و اپلیکیشن، میگوید: «این مطالعه یکی از اولین شواهدی را ارائه میدهد که ثابت میکند ابزارهای هوش مصنوعی مولد، مانند ChatGPT، میتوانند الگوهای طراحی فریبنده یا دستکاریکننده را در طراحی آثار وارد کنند.» او نگران است که چگونه فناوریای مانند هوش مصنوعی مولد، که به طور گسترده استفاده میشود، میتواند چنین الگوهایی را عادیسازی کرده و تلاشهای سالها تحقیق و طراحی اخلاقی را تحتالشعاع قرار دهد. او اضافه میکند: «این گنجاندن روشهای طراحی مشکلساز در ابزارهای هوش مصنوعی مولد، پرسشهایی در زمینه قوانین طراحی و اخلاق مداری مطرح میکند، بهویژه در مورد مسئولیت توسعهدهندگان و کاربرانی که ممکن است بهطور ناخودآگاه از این طراحیها استفاده کنند.»

کاریسا ولیز، دانشیار اخلاق هوش مصنوعی در دانشگاه آکسفورد، نیز این نگرانیها را تأیید میکند و میگوید: «از یک سو این مسئله شوکهکننده است، اما از سوی دیگر نباید باشد. تقریباً همه ما این تجربه را داریم که اکثر وبسایتهایی که بازدید میکنیم الگوهای تاریک دارند، درست است؟» او توضیح میدهد که چون سیستمهای هوش مصنوعی مولد، از جمله ChatGPT، با دادههای وسیعی از وب آموزش دیدهاند که شامل این الگوهای دستکاریکننده نیز میشود، جای تعجب نیست که ابزارهای هوش مصنوعی نیز این مشکلات را بازتولید میکنند. ویلیز تأکید میکند: «این موضوع نشان میدهد که ما در حال طراحی فناوری به شکلی غیراخلاقی هستیم. اگر ChatGPT وبسایتهای غیراخلاقی میسازد، دلیلش این است که با دادههای وبسایتهای غیراخلاقی آموزش دیده است.»

ویلیز همچنین از این نگران است که یافتهها یک مشکل گستردهتر را برجسته میکنند؛ اینکه هوش مصنوعی مولد بدترین مشکلات اجتماعی ما را بازتولید میکند. او اشاره میکند که بسیاری از شرکتکنندگان در مطالعه نسبت به وجود الگوهای طراحی فریبنده در صفحات تولید شده توسط هوش مصنوعی بیتفاوت بودند. از میان ۲۰ شرکتکننده، ۱۶ نفر اعلام کردند که از طراحیهای تولید شده توسط هوش مصنوعی راضی هستند و مشکلی در خروجی آن نمیبینند. ویلیز میگوید: «ما فقط کارهای غیراخلاقی انجام نمیدهیم؛ حتی مشکلات اخلاقی را نیز شناسایی نمیکنیم.»

البته قانون گذاری در زمینه الگوهای تاریک، در حوزههای قضایی اروپایی انجام شده و میتوان آن را برای جلوگیری از استفاده در طراحیهای تولید شده توسط هوش مصنوعی گسترش داد. همچنین، ایجاد محدودیتهایی برای سیستمهای هوش مصنوعی—هرچند ناقص—میتواند از گسترش عادتهای بد در دادههای آموزشی جلوگیری کند.

OpenAI، سازنده ChatGPT، هنوز پاسخی به در مورد یافتههای این مقاله نداده است. اما کالین گری پیشنهاد میکند: «این یافتهها نیاز به مقررات و محافظتهای روشن را نشان میدهد، زیرا هوش مصنوعی مولد در طراحی محصولات دیجیتال بسیار بیشتر بهکار گرفته میشود.»